Comment améliorer l'IA de n'importe quelle image avec une diffusion stable

Publié: 2023-07-17

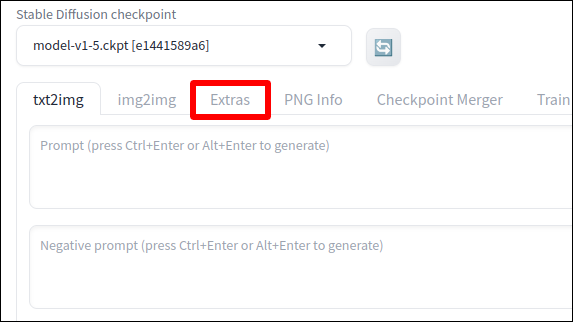

- Dans Stable Diffusion WebUI, cliquez sur l'onglet "Extras".

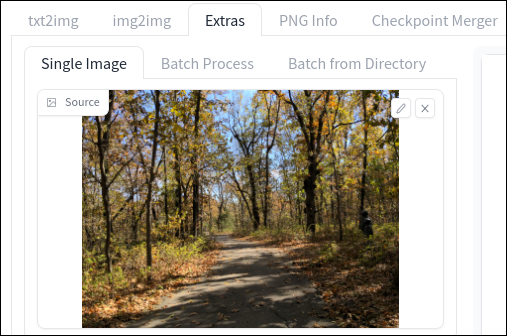

- Téléchargez l'image ou les images que vous souhaitez mettre à l'échelle.

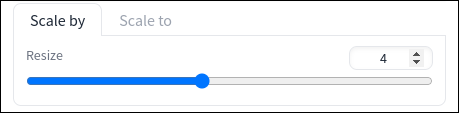

- Ajustez le curseur Redimensionner pour choisir la résolution souhaitée.

- Choisissez un upscaler à utiliser.

- Cliquez sur "Générer".

Déçu par la faible résolution de vos créations Stable Diffusion ? Ou peut-être avez-vous des photos "réelles" plus anciennes que vous aimeriez mettre à l'échelle ? Stable Diffusion WebUI dispose d'outils pour cela, et nous vous guiderons tout au long du processus tout en partageant quelques conseils que nous avons appris en cours de route.

Remarque : dans ce guide, nous supposons que l'interface Web de diffusion stable d'automatic11111 est installée et en cours d'exécution. C'est l'édition définitive de Stable Diffusion et rend la mise à l'échelle (ainsi que de nombreux autres aspects du travail avec des images AI) beaucoup plus simple et intuitive par rapport à une installation Stable Diffusion standard.

Comment mettre à l'échelle des images en diffusion stable

Conseils pour de meilleurs résultats de mise à l'échelle

Comment mettre à l'échelle des images en diffusion stable

Que vous ayez une numérisation d'une ancienne photo, d'une ancienne photo numérique ou d'une image générée par l'IA basse résolution, démarrez Stable Diffusion WebUI et suivez les étapes ci-dessous.

1. Télécharger une image

Tous les outils de mise à l'échelle de Stable Diffusion sont situés dans l'onglet "Extras", alors cliquez dessus pour ouvrir le menu de mise à l'échelle.

Ou, si vous venez de générer une image que vous souhaitez mettre à l'échelle, cliquez sur "Envoyer vers Extras" et vous y serez redirigé avec l'image en place pour la mise à l'échelle. Sinon, vous pouvez glisser-déposer votre image dans le champ de téléchargement Extras.

Si vous avez plusieurs images que vous souhaitez mettre à l'échelle à la fois, passez à l'onglet "Traitement par lots" et déposez-en plusieurs à la fois. D'après mon expérience, cependant, cela ne fonctionne pas toujours, et

Étape 2 : Choisissez une taille

Utilisez le curseur "Redimensionner" pour ajuster la taille de l'image de sortie. Par défaut, vous utiliserez l'onglet "Scale By" qui vous permet de multiplier la résolution actuelle de l'image par un nombre donné. Ainsi, par exemple, si vous le réglez sur 2 et que votre image d'entrée est de 512 × 512, l'image sera mise à l'échelle en 1024 × 1024.

Alternativement, vous pouvez passer à l'onglet "Scale To" et entrer une résolution spécifique que vous souhaitez. Portez une attention particulière au rapport d'aspect actuel de l'image et décochez l'option "Recadrer pour ajuster" si vous ne voulez pas que les bords soient coupés.

Si vous envisagez de créer un fond d'écran, gardez à l'esprit que la plupart des téléphones modernes utilisent un format d'image 9:16, les tablettes utilisent 4:3 et les ordinateurs 16:9 (bien que les moniteurs ultra-larges atteignent 21:9).

Étape 3 : Choisissez un Upscaler

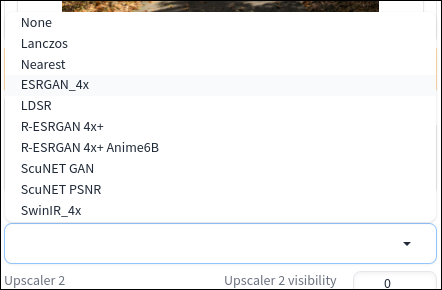

Maintenant, c'est là qu'il est facile de se sentir dépassé : vous avez à votre disposition plusieurs algorithmes de mise à l'échelle différents, tous avec des noms cryptés, et vous devez en choisir un.

Celui que vous devez choisir dépend en fin de compte du type d'image que vous mettez à l'échelle, comme une photo, une peinture, un dessin animé ou un autre type d'illustration de style "dessin animé". Différents algorithmes fonctionnent également à des vitesses différentes, cela peut donc également dépendre du type de hâte dans laquelle vous êtes.

Quel est le meilleur upscaler à diffusion stable ?

Expérimenter avec les différents algorithmes est le seul moyen de savoir avec certitude lequel des upscalers intégrés de Stable Diffucion est le mieux adapté à votre cas. Cela dit, si vous souhaitez une recommandation de base, ce sont généralement de bons choix :

- Photos : ESRGAN_4x

- Peintures : R-ESRGAN 4x+

- Anime: R-ESRGAN 4x + Anime6B

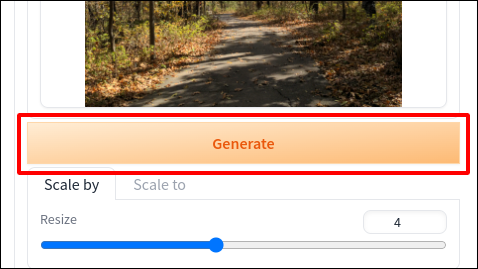

Étape 4 : Montez en gamme !

Une fois que vous avez vos paramètres en place, il est temps de passer à la vitesse supérieure. Appuyez sur ce gros bouton "Générer" pour commencer le processus.

La première fois que vous effectuez une mise à l'échelle avec un algorithme donné, Stable Diffusion devra télécharger les modèles appropriés. Attendez-vous donc à ce que l'exécution initiale prenne plus de temps (ce qui dépendra en partie de votre vitesse de connexion).

Une fois la mise à l'échelle terminée, vous trouverez les images de sortie dans le sous-répertoire extras-images de votre dossier outputs .

CONNEXION: Comment utiliser la diffusion stable pour créer des GIF et des vidéos AI

Conseils pour de meilleurs résultats de mise à l'échelle

Si les images ne ressemblent pas tout à fait à ce que vous attendiez, vous pouvez faire certaines choses pour obtenir de meilleurs résultats avec les outils de mise à l'échelle de Stable Diffusion.

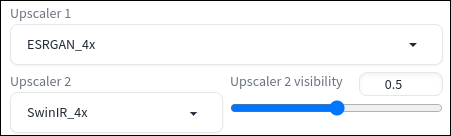

Essayez un combo Upscaler

Pour une conversion ascendante avancée, vous pouvez sélectionner un deuxième algorithme qui appliquera son effet à la même image, et les résultats des deux conversions ascendantes seront mélangés pour le produit final. (Pour être clair, un deuxième convertisseur ascendant ne doublera pas la résolution de sortie.) Ceci est utile si vous trouvez que deux convertisseurs ascendants différents produisent de meilleurs résultats pour des raisons différentes.

Par exemple, lors de mes tests, j'ai trouvé que ESRGAN_4x était le meilleur pour conserver les détails, mais que SwinIR avait moins de grain, tout en introduisant également des artefacts de mosaïque gênants. Je pouvais obtenir le meilleur des deux mondes en définissant ESRGAN_4x comme upscaler principal et SwinIR comme secondaire, avec une visibilité de 0,5.

Corriger les mauvais rapports d'aspect avec la peinture

Si vous avez une image que vous souhaitez utiliser avec un rapport d'aspect spécifique mais que l'image mise à l'échelle est trop haute ou trop large pour être utilisée sans recadrage, vous pouvez potentiellement résoudre ce problème à l'aide de l'outil "Outpainting" de Stable Diffusion. Il vous permet de générer "plus" de l'image, en ajoutant des images sur les côtés ou en haut et en bas qui n'étaient pas là auparavant.

Pour commencer à peindre, déposez votre image dans l'entrée img2img et recherchez le menu déroulant "Script" et sélectionnez Outpainting mk2 ou Poor Man's Outpainting. Ajustez les paramètres que vous voyez si nécessaire, puis cliquez sur "Générer".

Comme vous le découvrirez rapidement, il est difficile de bien peindre, et probablement un sujet pour un autre guide, en particulier avec un contenu d'image complexe comme des personnes et des animaux. Cela dit, juste en déconnant et en ne faisant pas trop de changements, j'ai pu générer cette version panoramique de mon image qui, à première vue, semble à moitié crédible.

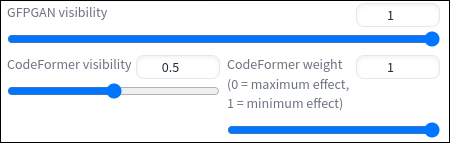

Restaurer les visages déformés avec GPFGAN ou CodeFormer

S'il y a le visage d'une personne dans l'image que vous agrandissez, elle peut facilement être déformée au point d'être méconnaissable. Vous avez sans doute vu certaines des interprétations plutôt horribles de visages humains de Stable Diffusion. Dans les deux cas, vous souhaitez déplacer les curseurs de visibilité GPFGAN ou CodeFormer. Chacun applique une couche de correction faciale pendant le processus de mise à l'échelle pour corriger ces yeux effrayants et ces rides bizarres.

Si vous utilisez CodeFormer, vous pouvez également ajuster le "poids" de son effet, ce qui revient à contrôler son niveau de force (tandis que le curseur de visibilité revient à régler la transparence de son calque de correction). Plus vous augmentez le poids, plus CodeFormer tentera de corriger. Cela peut améliorer ou dégrader l'image finale selon la situation. Vous devrez peut-être passer par quelques essais et erreurs pour obtenir le meilleur résultat possible.

GPFGAN vs CodeFormer pour la restauration faciale

Bien que les deux soient des outils performants, GPFGAN est généralement meilleur pour restaurer la structure d'un visage (yeux en particulier), mais CodeFormer est meilleur pour réparer les textures de la peau. GPFGAN a tendance à donner à la peau humaine un étrange aspect ultra-lisse, donc si vous remarquez que cela se produit, essayez CodeFormer à la place. Alternativement, combinez les deux et essayez d'obtenir le meilleur des deux mondes. Encore une fois, l'expérimentation est la clé.

En termes de vitesse, GPFGAN est légèrement plus rapide que CodeFormer. Donc, si vous cherchez à faire en sorte que votre mise à l'échelle se produise le plus rapidement possible, vous voudrez probablement vous appuyer sur GPFGAN.

CONNEXION: Comment créer des fonds d'écran impressionnants pour n'importe quel appareil avec MidJourney